終於有人清楚了解 GPT 的狀態!

在進行前訓練之前,有兩個準備步驟。

數據收集-從不同來源獲取大量數據(在這裡安德烈拉瑪混合物)

代幣化-單詞和整數之間的無損翻譯。

數據收集-從不同來源獲取大量數據(在這裡安德烈拉瑪混合物)

代幣化-單詞和整數之間的無損翻譯。

「你不應該只用它包含的參數量來判斷模型的力量」

LLama 在 GPT-3 中進行了 1-1.4 萬兆代幣與 300 億代幣進行培訓。

LLama 在 GPT-3 中進行了 1-1.4 萬兆代幣與 300 億代幣進行培訓。

「不幸的是,我沒有足夠的時間來探討變壓器的工作方式」 ![]() 一定要愛安德烈渴望教學!

一定要愛安德烈渴望教學!

我無法將這一點總結為一個推文。

我無法將這一點總結為一個推文。

以下是新聞網的一個例子,他在莎士比亞培訓了 GPT 模特

您可以看到 LM 如何更好地預測莎士比亞文本中的下一個單詞會出現的許多重複後,您可以看到繼續改進。

您可以看到 LM 如何更好地預測莎士比亞文本中的下一個單詞會出現的許多重複後,您可以看到繼續改進。

可以在這裡強烈地轉譯,但是,每次迭代,學員模型都會嘗試預測綠色代幣/整數(在圖中)之後會出現哪個令牌/整數,這是由訓練曲線描述了,它能夠預測下一個令牌的效果如何與原始文本相比。

關於 GPT-2,業界注意到,如果我們以特定的方式構建提示,並提供一些例子(Few Shot 提示),那麼基本模型將被「欺騙」,自動完成我們在提示中提供的指示。

Andrej 重複了幾次,目前可以從中學習的最好的開源模型可能是 LLama

$Meta Platforms(META.US$ 人工智能(由於 OAI 沒有發布關於 GPT-4 的任何內容)

GPT-2-已釋放 + 重量

GPT-3-通過 API 提供的基本模型(達文西)

GPT-4-無法通過 API 提供

$Meta Platforms(META.US$ 人工智能(由於 OAI 沒有發布關於 GPT-4 的任何內容)

GPT-2-已釋放 + 重量

GPT-3-通過 API 提供的基本模型(達文西)

GPT-4-無法通過 API 提供

基本模型不是助手,他們從基本意義上不「做你要求的事」。它們只是自動完成文本。

但是,如果您使用 Few-shot 提示來構建文檔,它將「欺騙」基本模型以認為它自動完成 AI 和人類之間的聊天

但是,如果您使用 Few-shot 提示來構建文檔,它將「欺騙」基本模型以認為它自動完成 AI 和人類之間的聊天

但這個技巧還不夠。所以我們正在轉到步驟 2。

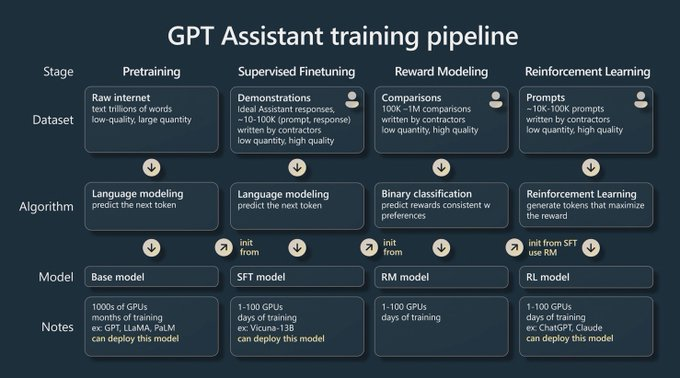

受監督的微調。

收集小但高質量(考慮人力承包商)指令數據集

現在繼續使用交換的數據集訓練模型,我們將獲得 SFT(受監控的微調)模型。

受監督的微調。

收集小但高質量(考慮人力承包商)指令數據集

現在繼續使用交換的數據集訓練模型,我們將獲得 SFT(受監控的微調)模型。

SFT 模型... 還不好,絕對不是 ChatGPT 質量。所以培訓繼續

使用 SFT 模型產生問題的輸出,用戶在 3 個版本之間查看和比較,並排名哪個是最好的,然後根據用戶的選擇重新培訓模型

使用 SFT 模型產生問題的輸出,用戶在 3 個版本之間查看和比較,並排名哪個是最好的,然後根據用戶的選擇重新培訓模型

這是通過選擇更好的投票的回應來完成的。例如,當你擊中時 ![]() 或者

或者 ![]() 在 ChatGPT 中,或選擇重生響應,這些信號對 RLHF 非常適合。

在 ChatGPT 中,或選擇重生響應,這些信號對 RLHF 非常適合。

Andrej 正在研究為什麼 RLHF 模型對我們「感覺」更好的潛在原因。至少在當一個好助手方面。

再次在這裡,如果有人還在閱讀,我會向您推薦視頻![]()

再次在這裡,如果有人還在閱讀,我會向您推薦視頻

有趣的是,Andrej 談到 RLHF 並不是對基本模型的嚴格改進。RLHF 模型具有較少的吸收力,因此其潛在的「創意」性較少。

因此,基本模型還是更好,因為它們仍然混亂。

因此,基本模型還是更好,因為它們仍然混亂。

這是 Berkley 的人根據排名對模特的當前狀態。

有趣的是,卡帕蒂說 GPT-4 是「迄今為止」最好的,但在圖表上,它的 1274 和克勞德的 1224 ELO 等級似乎並不是「到目前為止」

有趣的是,卡帕蒂說 GPT-4 是「迄今為止」最好的,但在圖表上,它的 1274 和克勞德的 1224 ELO 等級似乎並不是「到目前為止」

RLHF 車型排名更好,前 3 全都是 RLHF 模型,其餘的車型(據他所知是 SFT 模型)

哇!我們已經完成談話的上半部分了移至應用這些模型對問題。

哇!我們已經完成談話的上半部分了移至應用這些模型對問題。

然後,Andrej 進一步深入了解人類編寫這樣的陳述過程之間的區別

「加利福尼亞州的人口是阿拉斯加的 53 倍」

人類大腦經歷循環、事實檢查、計算、反思。

「加利福尼亞州的人口是阿拉斯加的 53 倍」

人類大腦經歷循環、事實檢查、計算、反思。

當 GPT 嘗試自動完成時,GPT 中沒有內部對話框。

它每個令牌花費相同的「計算」數量,無論令牌是需要查找的數字還是需要檢查的事實,但它們具有龐大的知識和完美的內存(上下文窗口)

它每個令牌花費相同的「計算」數量,無論令牌是需要查找的數字還是需要檢查的事實,但它們具有龐大的知識和完美的內存(上下文窗口)

思想鏈之類的方法通過問「讓我們一步一步思考」來為模型提供「更多代幣」或「更多時間思考」

這將使模型顯示它的工作效果,這將給它「時間思考」以獲得更好的答案

這將使模型顯示它的工作效果,這將給它「時間思考」以獲得更好的答案

現在安德烈正在進行自我反思作為一種方法。

模型可能會「卡住」,因為他們無法取消已採樣的代幣。

想像自己說錯誤的單詞,在中間停下自己「讓我重寫」,然後重新開始句子

模型可能會「卡住」,因為他們無法取消已採樣的代幣。

想像自己說錯誤的單詞,在中間停下自己「讓我重寫」,然後重新開始句子

模特兒沒有那麼奢華,所以他們可能會被困在錯誤的道路上...

但是像自我反思這樣的例子表明,要求模型檢視其輸出,判斷它,會給模型「第二次更改」或者另一次通過輸出的推理,從而改善了結果!

但是像自我反思這樣的例子表明,要求模型檢視其輸出,判斷它,會給模型「第二次更改」或者另一次通過輸出的推理,從而改善了結果!

我喜歡它,Andrej 將思考快速和慢速-系統 1 和系統 2 的思維模型用於 LLM。

這些技術,例如 CoT,自我反思和最近發布的思想樹,是我們打造系統 2 的嘗試,即更慢,更有意識的思維

這些技術,例如 CoT,自我反思和最近發布的思想樹,是我們打造系統 2 的嘗試,即更慢,更有意識的思維

免責聲明:社區由Moomoo Technologies Inc.提供,僅用於教育目的。

更多信息

評論

登錄發表評論