關於 Nvidia 在 GTC 上推出的「世界上最強大的 AI 芯片」應該了解的內容

$英偉達(NVDA.US$不可缺少的 H100 AI 芯片推動該公司進行了數億美元的估值,可能超越這些巨頭的價值 $谷歌-A(GOOGL.US$ 和 $亞馬遜(AMZN.US$。隨著競爭對手努力保持步伐, 英維亞可能通過推出先進的布萊克威爾 B200 GPU 和強大的 GB200「超級芯片」來進一步其主導地位。

Hopper 很棒,但我們需要更大的 GPU,」Nvidia 首席執行官黃詹森週一在該公司在加利福尼亞的開發人員會議上表示。

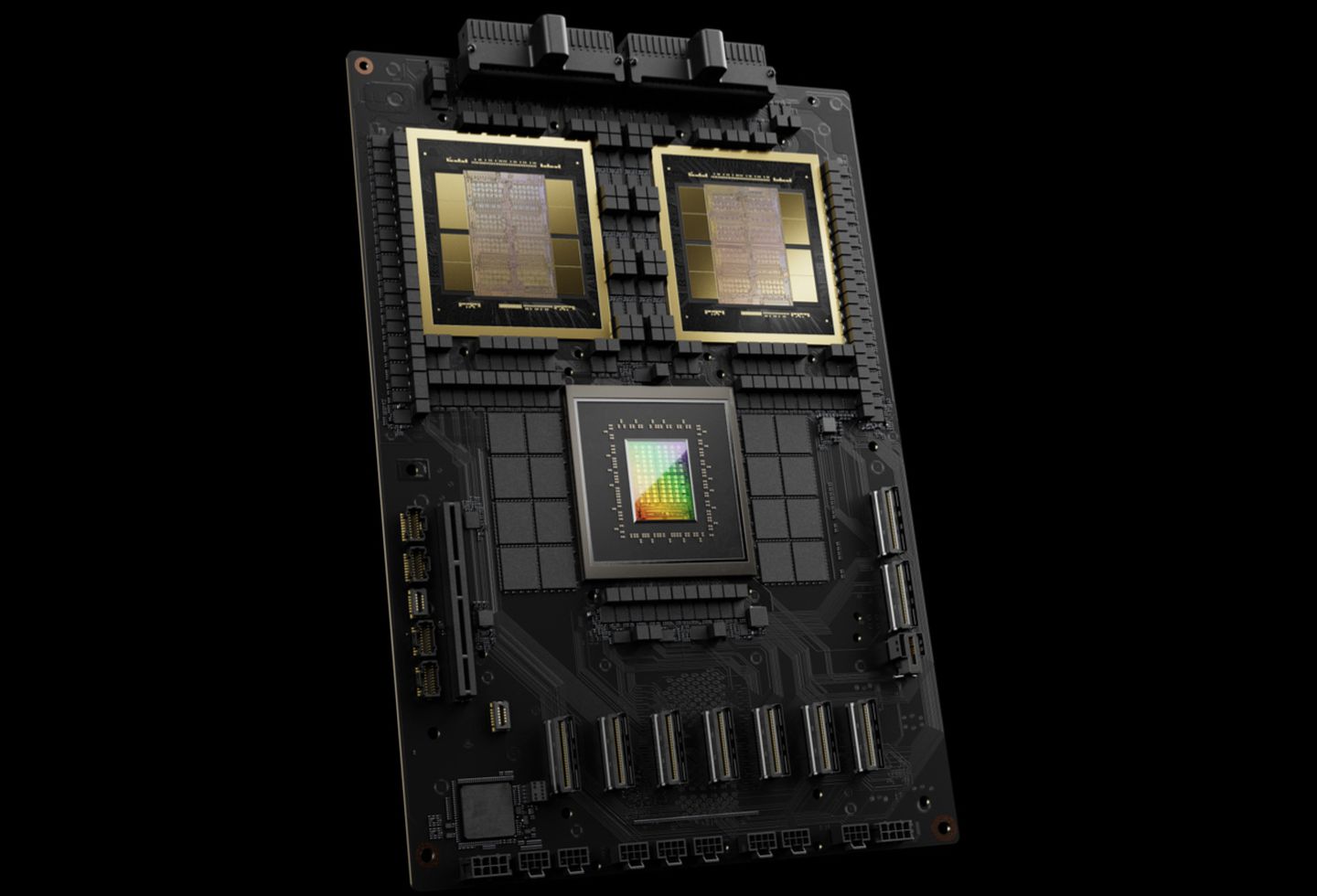

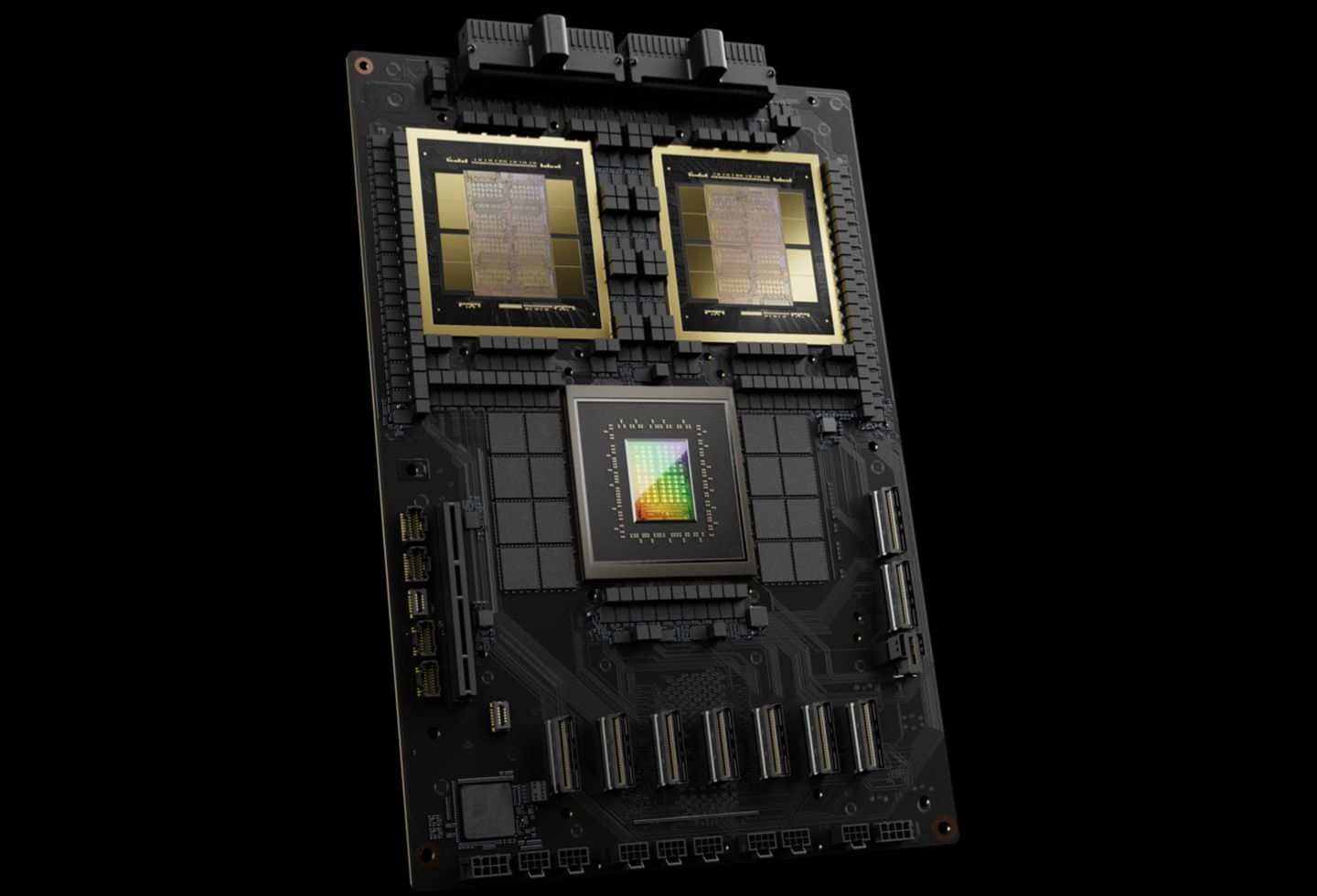

全新 GB200 超級晶片

英維亞的新 B200 GPU 擁有高達 20 百兆平方比的 FP4 性能,具有 208 億晶體管,而 GB200「超級晶片」可將兩個 B200 GPU 與單一 Grace CPU 配對,與之前型號相比,大型語言模型 (LLM) 推論工作負載的效能高達 30 倍,而且效率顯著更高, 降低成本和能源高達 H100 的 25 倍。 對於訓練具有 1.8 萬億參數的 AI 模型,其中 8,000 Hopper GPU 曾經需要 15 兆瓦的功率,現在只需要 2,000 個 Blackwell GPU,只需使用四兆瓦。 GB200 在 GPT-3 LLM 基準上提供七倍的性能和四倍的訓練速度,具有 175 億參數的參數。 Nvidia 還強調,其新技術顯著減少了 GPU 間通信所花費的時間,從而允許更多實際運算。

Nvidia 目標是批量購買這些 GPU,並推出了 GB200 NVL72 等大規模配置,該配置將 36 個 CPU 和 72 個 GPU 集成到單一液體冷卻機架中,提供高達 720 PB 的人工智能培訓或 1.4 exaflops(1,440 平方秒)的推論能力。這個機架裝有近兩英里的纜線和 5,000 個單獨電纜,可支援多達 27 萬億參數的型號。主要的雲服務提供商,包括亞馬遜,谷歌, $微軟(MSFT.US$,以及 $甲骨文(ORCL.US$,他們計劃將這些 NVL72 機架納入其產品中,儘管他們的確切購買數量尚未指定。

分析師的觀點

英維亞通過其最新的人工智能超級計算機 DGX 超級電腦,配備 GB200 格雷斯·布萊克韋爾超級芯片,推進人工智能的前沿。這台 AI 超級計算機擁有驚人的 11.5 exAFLOP 的 FP4 精度計算能力,並具有先進的液體冷卻架構,展示了 Nvidia 致力於高效能、節能的 AI 解決方案。 SuperPod 將通過啟用數億個參數的模型處理,重新定義人工智能研究和開發來革新人工智能。作為基礎技術的供應商,Nvidia 的 DGX SuperPod 將該公司定位為人工智能創新的關鍵參與者,並且在人工智能培訓領域的領導者,儘管競爭日益增加。

隨著 DGX 超級 PODS 的推出, Nvidia 強化其策略,以滿足對複雜 AI 模型的日益增長需求,並保持其作為 AI 高性能運算的頂級提供商的地位。

儘管 Nvidia 尚未披露新推出的 GB200 或其結合它的系統的定價,但滙豐預計為 26 財政年度提供 35,000 個機架,營收潛力為 39 億美元。

GB200 平台將專注於 25 財年將從 GH200 人工智慧平台轉移,將內部的 Grace Hopper ARM 型 CPU 與兩個 B200 人工智慧 GPU 整合, 與之前的 H100 AI 平台相比,提供更具成本效益的替代方案,平均售價 (ASP) 更高。 這項新配置不僅降低整體晶片成本,還為客戶提供更大的靈活性,從每個模組需要八個 GPU 的要求轉為 GB200 只需兩個 GPU。 Nvidia 的策略還可能包括朝向機架式平台邁向,可能為每個機架產生大量收入,並導致 GB200 平台的總收入大幅增加。 靈敏度分析表明,人工智能機架的增加可能會導致 26 財年銷售和收益上升 4% 至 11%,以及每股收益範圍和估值較高,假設目標價格對收益比率 (PER) 為 30 倍。

英維達推論微服務(NIM)

英維亞在其企業軟件訂閱陣容中引入 NIM(英維亞推論微服務), 旨在簡化現有 Nvidia GPU 進行推論任務的使用 — 比訓練新 AI 模型相比,運行 AI 軟體的計算需求較少。 該服務使組織能夠利用他們已經擁有的大量 Nvidia GPU 來操作自己的 AI 模型,從而提供了從 OpenAI 等公司購買 AI 結果作為服務的替代方案。

該公司的策略包括鼓勵擁有基於 NVIDIA 的服務器的客戶訂閱 Nvidia 企業,每年每 GPU 的費用為 4,500 美元。 Nvidia 計劃與微軟和 Hugging Face 等 AI 公司合作,以優化 Nvidia 芯片的 AI 模型,確保跨兼容硬件的流暢運行。有了 NIM,開發人員可以更有效率地將這些模型部署在其本機伺服器或 Nvidia 的雲端伺服器上,繞過複雜的設定程序。根據 Nvidia 稱,該軟件還將促進配備 GPU 的筆記本電腦上的 AI 應用,為雲服務器依賴提供替代方案。

資料來源:The Verge、英維達、滙豐、CNBC、福布斯、科技危機

免責聲明:此内容由Moomoo Technologies Inc.提供,僅用於信息交流和教育目的。

更多信息

評論

登錄發表評論

frank Crane_3546 : 喜歡它。Nvidia 是一家超市場,提供平台芯片解決方案軟件 SaaS 解決方案!!!!!