关于Nvidia在GTC上发布的 “世界上最强大的AI芯片”,你应该知道什么

$英伟达(NVDA.US$不可或缺的H100 AI芯片推动该公司估值达到了数万亿美元,有可能超过巨头的价值 $谷歌-A(GOOGL.US$ 和 $亚马逊(AMZN.US$。当竞争对手争先恐后地跟上步伐时, 英伟达可能会通过推出先进的布莱克韦尔B200 GPU和强大的 GB200 “超级芯片” 来进一步巩固其统治地位。

Hopper太棒了,但我们需要更大的GPU。” 英伟达首席执行官黄延森周一在加利福尼亚举行的公司开发者大会上表示。

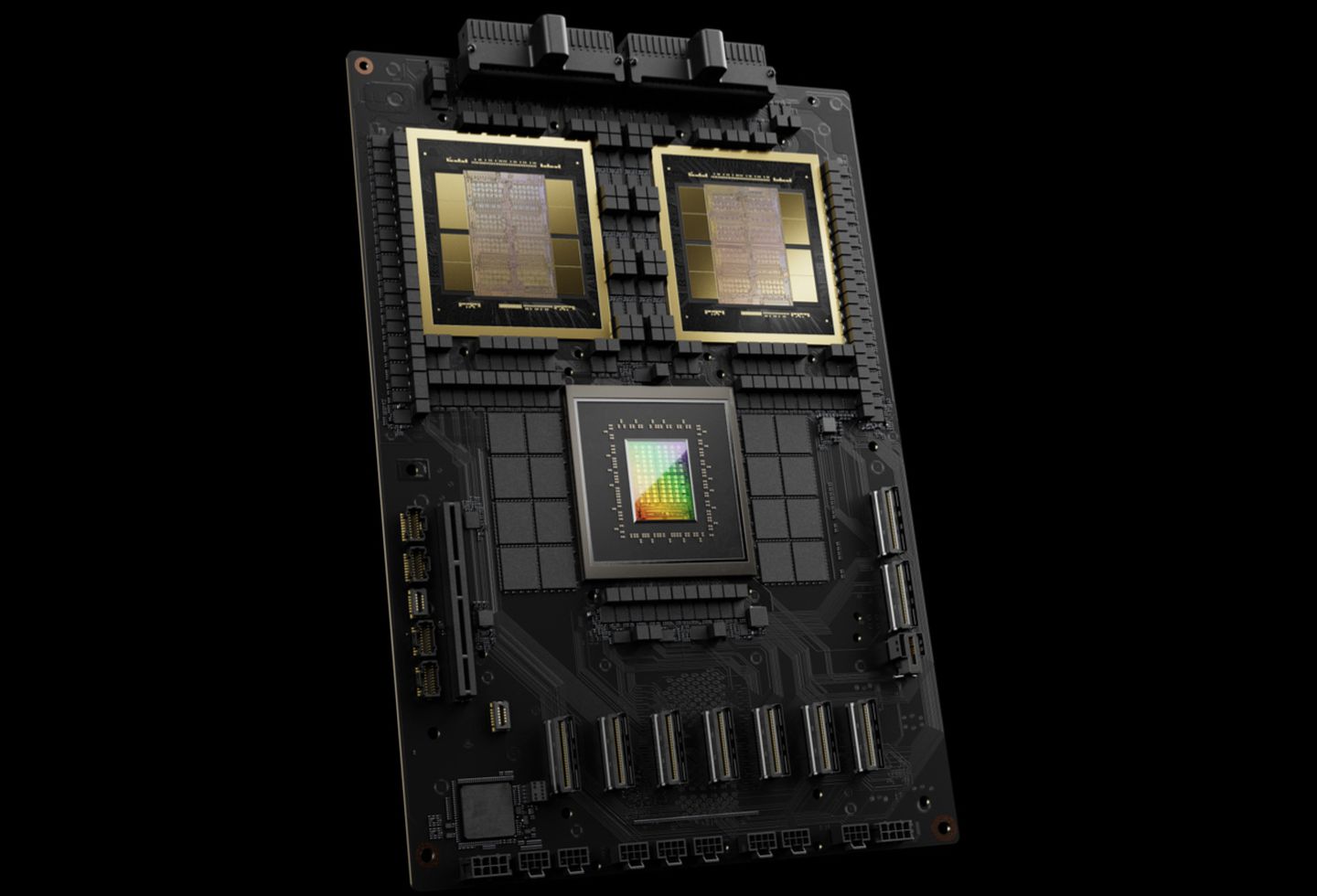

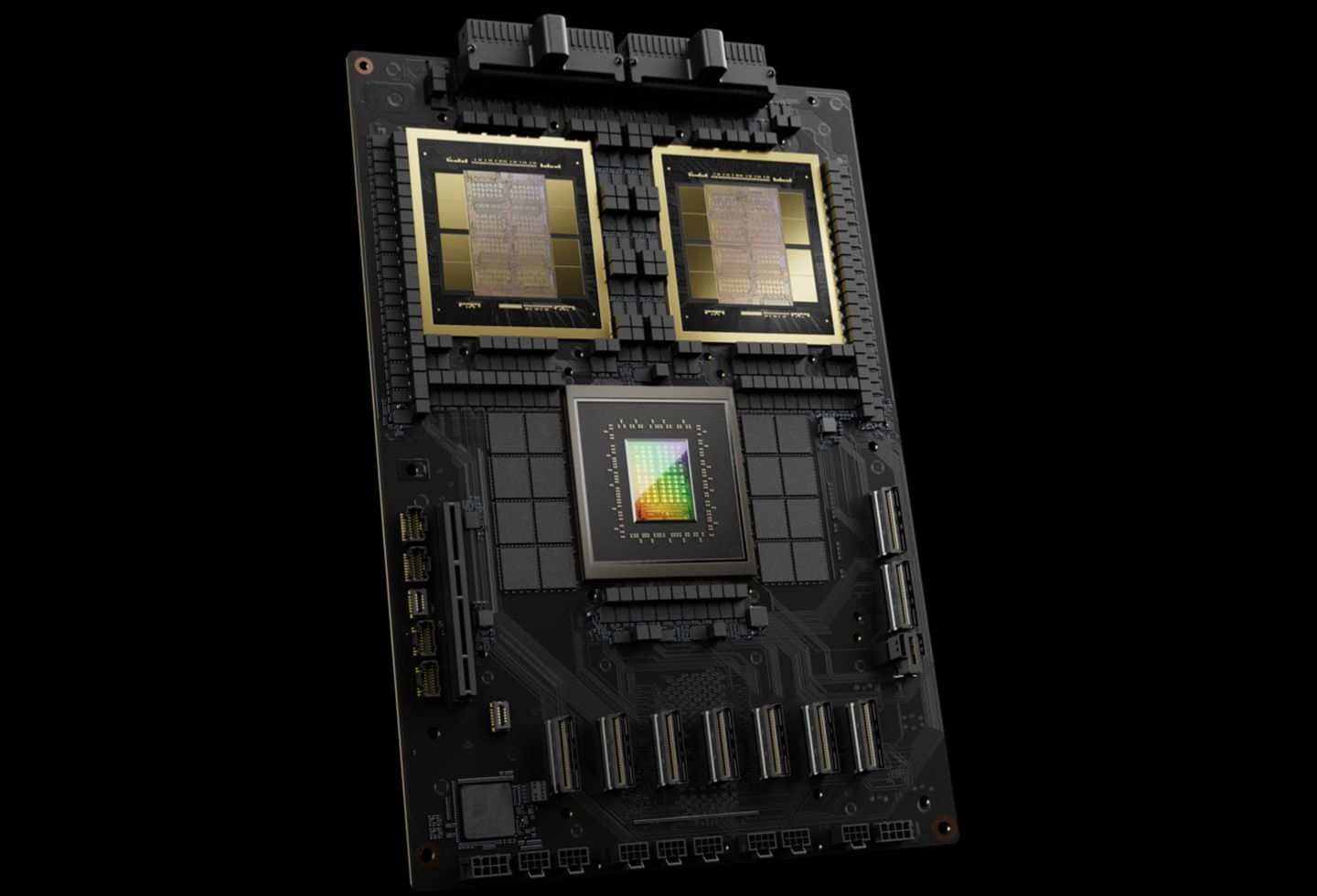

全新 GB200 超级芯片

Nvidia 的新款 B200 GPU 拥有高达 20 千亿次浮点运算的 FP4 性能和 2080 亿个晶体管,而 GB200 “超级芯片” 将两个 B200 GPU 与一个 Grace CPU 配对,与之前的型号相比,可为大型语言模型 (LLM) 推理工作负载提供高达 30 倍的性能,而且效率要高得多, 与 H100 相比,成本和能耗最多可降低 25 倍。 要训练具有 1.8 万亿个参数的人工智能模型,其中 8,000 个 Hopper GPU 曾经需要 15 兆瓦的功率,而现在只需要 2,000 个 Blackwell GPU,仅消耗 4 兆瓦。 在具有 1750 亿个参数的 GPT-3 LLM 基准测试中,GB200 的性能和训练速度是其七倍。 Nvidia 还强调,其新技术显著减少了 GPU 间通信所花费的时间,从而实现了更多的实际计算。

英伟达的目标是批量购买这些显卡,并推出了诸如 GB200 NVL72 之类的大规模配置,它将36个CPU和72个显卡集成到一个液冷机架中,提供高达720千亿次浮点的人工智能训练或1.4亿次浮点运算(1,440千亿次浮点)的推理能力。该机架装有近两英里的电缆和 5,000 条单独的电缆,可支持多达 27 万亿个参数的模型。主要的云服务提供商,包括亚马逊、谷歌、 $微软(MSFT.US$,以及 $甲骨文(ORCL.US$,正计划将这些 NVL72 机架纳入其产品中,尽管他们的确切购买数量尚未确定。

分析师的看法

英伟达正在凭借其最新的人工智能超级计算机——配备 GB200 Grace Blackwell 超级芯片的 DGX SuperPod 推动人工智能前沿的发展。这台 AI 超级计算机在 FP4 精度下拥有惊人的 11.5 exaFLOps 计算能力,并采用先进的液冷架构,展示了 Nvidia 致力于提供高性能、节能的人工智能解决方案。 SuperPod将通过支持处理具有数万亿个参数的模型来彻底改变人工智能,重新定义人工智能的研发。作为基础技术提供商,尽管竞争日益激烈,英伟达的DGX SuperPod仍将公司定位为人工智能创新的关键参与者和人工智能训练领域的领导者。

随着 DGX SuperPod 的推出, Nvidia 加强了其战略,以满足对复杂人工智能模型不断增长的需求,并保持其作为人工智能高性能计算顶级提供商的地位。

尽管英伟达尚未透露新推出的 GB200 或包含该产品的系统的定价,但汇丰银行预计26财年将有35,000个机架,收入潜力为397亿美元。

GB200 平台将在 25 财年将重点从 GH200 人工智能平台转移出去,它将内部基于 Grace Hopper ARM 的 CPU 和两个 B200 AI GPU 集成在一起, 与之前的H100 AI平台相比,提供了更具成本效益的替代方案,平均销售价格(ASP)更高。 这种新配置不仅降低了整体芯片成本,还为客户提供了更大的灵活性,从要求每个模块八个 GPU 转变为 GB200 仅需要两个 GPU。 Nvidia 的战略还可能包括向基于机架的平台过渡,这有可能为每个机架带来可观的收入,并导致 GB200 平台的总收入大幅增加。 灵敏度分析表明,假设目标市盈率(PER)为30倍,AI机架的增加可能导致26财年的销售和收益增长4%至11%,同时每股收益范围和估值也有所提高。

Nvidia 推理微服务 (NIM)

英伟达已在其企业软件订阅阵容中引入了NIM(英伟达推理微服务), 旨在简化现有 Nvidia GPU 在推理任务中的使用——与训练新的 AI 模型相比,运行 AI 软件的计算需求更少。 该服务使组织能够利用他们已经拥有的大量 Nvidia GPU 来运行自己的人工智能模型,为从 OpenAI 等公司购买人工智能结果作为服务提供了一种替代方案。

该公司的战略包括鼓励使用基于NVIDIA的服务器的客户以每GPU每年4500美元的费用订阅Nvidia企业版。 英伟达计划与微软和Hugging Face等人工智能公司合作,优化英伟达芯片的人工智能模型,确保兼容硬件上的平稳运行。借助 NIM,开发人员可以绕过复杂的设置程序,更高效地将这些模型部署到本地服务器或 Nvidia 的云服务器上。根据Nvidia的说法,该软件还将促进配备 GPU 的笔记本电脑上的人工智能应用,为依赖云服务器提供替代方案。

来源:The Verge、Nvidia、汇丰银行、CNBC、福布斯、Tech Crunch

免责声明:此内容由Moomoo Technologies Inc.提供,仅用于信息交流和教育目的。

更多信息

评论

登录发表评论

frank Crane_3546 : 喜欢它。Nvidia 是一个提供平台芯片解决方案软件 SaaS 解决方案的超市场!!!!!